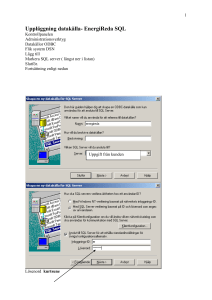

ETL-verktyg för datavaruhus

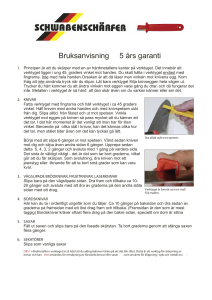

advertisement