Linjär Algebra 764G01: Kommentarer och läsanvisningar till

advertisement

Linjär Algebra 764G01: Kommentarer och läsanvisningar till kursboken

Här följer kommentarer om sånt i boken som kan behövas förtydligas samt anvisningar om

vad som ska läsas, eller snarare vilka delar som inte måste läsas.

Allmänt gäller att ni ska känna till de flesta satser och propositioner (dessa ord betyder

egentligen samma sak, men ofta brukar man använda ordet sats för viktigare resultat). Ni

behöver kunna använda många av dem men det krävs inte att ni kan citera dem eller kunna

bevisa satserna, med undantag för en del som bör behärskas hyfsat av den som vill uppnå

VG-nivå. Det är ändå viktigt för alla att läsa bevisen för att förstå alla nya begrepp, resultat

och metoder! Dessutom är det viktigt att öva sig i och vänja sig vid att läsa matematik. Dock

är det vissa bevis som är för omfattande och invecklade för att platsa i denna kurs. Därför

finns i följande läsanvisningar för att underlätta självstudierna angivet vad som är okej att

hoppa över.

Det finns några tryckfel i boken, errata finns på bokens websida: http://linjaralgebra.se/. Där

finns även lösningar till flertal uppgifter.

Kapitel 1. Geometriska vektorer

Ett ganska omfattande mycket viktigt första kapitel. T.ex. ska vi längre fram i kursen se att

ortogonal projektion har med minsta kvadrat-metoden/linjär regression att göra. Poängen

med denna geometri är inte trianglar och linjer i rummet utan att ni ska ha en grund för att

senare kunna generalisera till högre-dimensionella ”rum” där mängder av data kan ses ligga

approximativt i s.k. hyperplan.

I kapitlet används trigonometri. Kompletterande material om detta delas ut. Det går också

bra att repetera i matteboken från grundkursen.

Exempel 1.12 kan lätt missförstås. Span {v} är linjen L som går genom origo och har riktningsvektorn v. Linjen som diskuteras i exemplet går genom två punkter A och B men kanske

inte genom origo. Denna linje är ”likadan” (det är ju också en linje!) som den genom origo

och kan (med ordvalet i boken) ”identifieras” med Span {v}.

Definition 1.24 av spegling kan kännas omständlig. Det räcker att man kan rita en förklarande

figur och räkna exempel utifrån den — detta visas på föreläsningen.

I avsnitt 1.4 om vektorprodukt behöver ni inte lära er om höger- och vänster-orientering och

bevisen till propositioner 1.31 och 1.32 ingår ej.

Obs. tryckfel på s. 45. Se bokens errata.

I avsnitt 1.6.3 härleds två formler för avstånd. Lär dig inte dessa utantill. Det är mycket

bättre att bara lära sig projektionsformeln och sedan använda den.

I lösningarna till uppgifter i boken används beteckningen v = (1 2 3)t med ett litet t, vilket

1

!

står för transponat och betyder helt enkelt v =

1

2 .

3

Läs avsnitt 4.1 om vektorer i högre dimensioner ihop med detta kapitel.

Det är många rekommenderade uppgifter till detta kapitel men det är inte nödvändigt att

räkna alla om man inte hinner. Några kan vara bra till repetition. Om du vill göra fördjupningsuppgifterna kan du hoppa över några andra istället.

Notation som används:

Längden, även kallad normen, av en vektor v betecknas ||v||. På föreläsningarna används |v|,

vilket också är en vanlig beteckning. (Enkelstreck används även för absolutbeloppet av ett

tal, t.ex. | − 5| = 5.)

R står för mängden av alla reella tal (=’vanliga tal’) och ∈ betyder tillhör. Alltså betyder

c ∈ R att c är ett reellt tal, det utläses ”c tillhör R” eller ”c (ligger) i R” . c ∈ R\{0}

betyder att c är ett reellt tal men inte talet 0.

För att beteckna mängder används ofta klammrar {...}, t.ex. mängden {4, 0, 6} som har de

tre elementen 0, 4 och 6. Ofta anges vilka elementen i mängden är med en beskrivning, som

i M = {cv : c ∈ R}. Detta är mängden av alla vektorer cv sådana att c är ett reellt tal.

Exempelvis vektorn −5v är ett av elementen M .

För dig som vill ha VG:

Bevisen till Prop. 1.16 och första punkten i Prop. 1.19 (dessa är enkla, eg. godkänt-nivå).

Prop. 1.32 använder vi inte i kursen men för VG bör man kunna dessa räkneregler. Beviset

ingår ej. Jämför gärna med Prop. 1.19 om skalärprodukt.

Bevis Sats 1.38.

Se även Prop. 4.5 enligt anvisningar för kapitel 4.

Kapitel 2. Matriser

Tidigt i kursen kommer vi gå igenom avsnitt 2.1 och 2.3 samt endast en sida av 2.2,nämligen

Def. 2.22 och Sats 2.24 om determinanter för 2 × 2-matriser. Resten av avsnitt 2.2 kommer

ihop med kapitel 6.

Ett begrepp som inte tas upp i boken men som ni måste känna till är spåret av en matris.

Spåret av en kvadratisk matris A skrivs Tr A (’Tr’ står för trace, ibland används ’Sp’ på

svenska). Spåret är det tal man får om man summerar elementen på diagonalen, dvs

Tr A =

n

X

aii

i=1

för en n × n-matris med element aij .

Ett mycket bra tydligt kompletterande material rekommenderas:

2

www.math.kth.se/∼kpetters/avsnitt2.pdf (länk finns på kurshemsidan)

Sida 1 till 8 + halva 15 till halva 16 motsvarar ungefär avnsitt 2.1. (Resten från sida 10 och

framåt kommer vi behandla senare i samband med kapitel 5.)

Kapitel 2 behandlar bara små matriser. Läs avsnitt 4.2 om matriser i högre dimensioner ihop

med detta kapitel. Eftersom vi inte kommer diskutera den sk induktionsprincipen behöver ni

inte bry er om den delen av beviset till proposition 4.27. Detsamma gäller för andra bevis

där man hänvisar till induktionsprincipen.

För dig som vill ha VG:

Bevis av räkneregler i Prop. 2.11 och 2.16 för 2 × 2 och 3 × 3-martiser, antingen så som det

görs i boken eller helt enkelt genom att skriva ut alla koordinater (vilket blir längre att skriva

men det går).

Se även Prop. 4.27 enligt anvisningar för kapitel 4.

Kapitel 3. Geometriska linjära avbildningar

De två villkoren i Definition 3.1 av linjär avbildning är viktiga. Funktioner som uppfyller

den första, f (u + v) = f (u) + f (v), sägs vara additiva. Funktioner som uppfyller den andra,

f (cv) = c f (v), är homogena.

Avsnitt 3.6 ingår först i samband med kapitel 6.

Från avsnitt 3.7 ingår endast Definition 3.35 av affin avbildning. En sådan funktion får man

om man först tar en linjär avbildning och sedan lägger till en konstant vektor. Bra att känna

igen när ni stöter på sådana uttryck senare.

Läs även avsnitt 4.3 om linjära avbildningar i godtycklig dimension i samband ihop med

kapitel 3.

För dig som vill ha VG:

Bevis Prop. 3.22.

Se även Sats 3.11 och 4.33 enligt anvisningar för kapitel 4.

Kapitel 4. Rummet Rn

Här generaliseras det som gjorts i kapitel 1-3 i planet och rummet till att gälla vektorer,

matriser och linjära avbildningar i högre dimensioner/med fler element. Vi går igenom detta

kapitel parallellt med de föregående kapitlen.

För dig som vill ha VG:

Bevis Prop. 4.5. Det är många punkter i denna proposition men om du kan bevisa några av

3

punkterna (förstår vad du gör — inte bara skriver av) i så kan du klara av de andra också.

Kunna bevisa Prop. 4.27 för två och för tre matriser (d.v.s. r = 2 eller r = 3) och se att det

generaliserar till godtyckligt antal matriser. Se början av bokens bevis (induktion behövs ej.)

Om f (v) = Av, bevisa att A = (f (e1 ) f (e2 ) · · · f (en )) genom att ”stoppa in” en allmän

vektor v i f . Se beviset av Sats 4.33 (Bassatsen). Notera att det är en generalisering av Sats

3.11 så titta gärna på det beviset först!

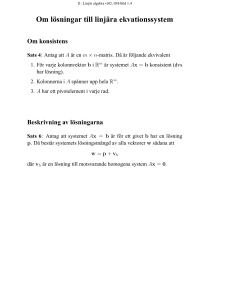

Kapitel 5. Linjära ekvationssystem

I en del av problemen vi sett hittills i kursen har vi löst system av linjära ekvationer. Här

ska vi se hur man kan lösa dem på ett strukturerat sätt. Vi gör det för hand för små system,

men samma metod används för större system och lösas med hjälp av dator.

Det mesta ingår, men det kapitlet innehåller lite väl många propositioner och satser. Det

väsentliga är att ni kan lösa ett linjärt ekvationssystem och att ni utifrån räkningen kan se

vilken typ av lösning det blir och vilka andra möjligheter som skulle kunna ske (det klarnar

när vi räknar!). Det är alltså inte viktigt att kunna alla satser. De viktigaste kommer tas upp

på föreläsningen.

Följande är okej att hoppa över:

Sidorna 165-167, bevis till Sats 5.28, samt Följdsats 5.29 och dess bevis.

Ett mycket bra tydligt kompletterande material rekommenderas starkt:

www.math.kth.se/∼kpetters/avsnitt1.pdf (länk finns på kurshemsidan)

Börja gärna läsa detta (motsvarar ungefär avsnitt 5.1-5.5). I alla räkningar i här markeras det

tydligt vilka radoperationer som utförs. Dessutom är en linje utritad som skiljer koefficientdelen från konstant-vektorn. Ta för vana att göra så!

När du läser i kursboken, rita i totalmatriserna in ett streck mellan koefficient-delen från

konstant-vektorn så blir det lättare att följa.

Jag kommer förespråka att man arbetar på totalmatrisform några steg längre än vad som

görs i exemplen i boken, vilket är mer likt det kompletterande materialet.

Nu är det även dags att räkna matrisinverser vilket man även kan läsa om i

www.math.kth.se/∼kpetters/avsnitt2.pdf

från sida 10 och framåt (detta är samma text om matriser som hänvisades till i kapitel 2.)

Avsnitt 5.6 behandlar om minsta kvadrat-metoden/linjär regression är mycket viktigt för er

utbildning! Eftersom det är kortfattat i boken ingår även följande text:

www.math.kth.se/∼lhakan/Nr8april4.pdf (länk finns på kurshemsidan)

För dig som vill ha VG:

Bevis prop. 5.2 och sats 5.33.

Bevis för att matrisen At A är kvadratisk och symmetrisk; beviset finns i det kompletterande

materialet.

4

Kapitel 6. Determinant

Börja med att gå tillbaka till s.70 och repetera om determinanten för 2 × 2-matriser.

På s.73 införs determinanten för 3 × 3-matriser och beräkning med Sarrus regel. Metoden

med ”triangulering” i kapitel 6 fungerar alltid, men ibland är det lättare att använda Sarrus

regel. Tyvärr kan den inte generaliseras enkelt till större matriser.

I avsnitt 6.1 ges den allmänna definitionen av determinanten och tre viktiga resultat (Prop.

6.3, Prop. 6.4, Sats 6.5).

Avsnitt 6.2 härleder en summa-formel för determinanten. Detta ingår inte i kursen, förrutom

att man ska ha sett resultatet Sats 6.14 eftersom denna tas som definition i många framställningar av linjär algebra. Formeln nämns på föreläsningen.

Avsnitt 6.3 innehåller några resultat som är rätt enkla att lära sig:

Börja läs vid Prop. 6.17 (ej bevis) och exempel 6.18, samt Prop. 6.19 (ej bevis) och exempel

6.20. Hoppa till Sats 6.22 (ej bevis) och Prop. 6.23 med bevis och exempel 6.24.

Determinanter anger volym-förändringen som linjära avbildningar ger. Läs avsnitt 3.6.

Slutligen vill jag nämna att det finns en annan vanligt förekommande metod för beräkning

av determinanter, s.k. ”utveckling efter rad rad eller kolonn”, vilken vi dock inte har tid att

gå igenom. Att kunna överföra en matris på triangulär form räcker.

För dig som vill ha VG:

Bevis prop. 6.3 och sats 6.23.

En tillräckligt bra förståelse av avsnitt 6.1 för att kunna lösa de uppgifter som är listade

kursivt i kursplaneringen.

Kapitel 7. Baser

Detta är ett omfattande kapitel så räkna med att det tar lite extra tid att läsa ordentligt.

Vissa delar är onödigt generella för oss så vi bortser från dem; se nedan.

I en allmän bas behöver vektorerna varken vara ortogonala eller normerade. Men förutom i

enstaka uppgifter kommer vi endast använda ON-baser när vi räknar i denna kurs.

Prop. 7.12 och Sats 7.13 ingår inte.

Trots att Sats 7.14 är viktig och enkel att formulera är beviset lite för avancerat för oss. Men

den som är intresserad kan gärna göra ett försök.

Formeln för koordinatbyte i ekvation (7.1) är viktig: x̄ = F x̄F .

Notera att matrisen för standardbasen blir identitetsmatrisen, E = I = (ē1 ē2 . . . ēn ), så att

koordinaterna x̄E i denna bas utifrån formeln blir just x̄ som de borde: x̄ = E x̄E = x̄E .

5

Sats 7.19 och därmed s.214 till halva s.215 behövs inte.

Definition 7.21: bara den sista halvan ingår (gäller avbildningar med kvadratiska matriser).

Ej Sats 7.22 samt exempel 7.23. Dock ska vi använda specialfallet av Sats 7.22 för linjära

avbildningar med kvadratiska matriser. Vi tar upp det på föreläsningen.

Ej exempel 7.3.

Utöver det om ON-baser i boken ska vi gå igenom den s.k. Gram-Schmidt-metoden. Den

används för att bestämma en ON-bas utifrån vektorer som inte är ortogonala eller normerade.

Tre sidor om detta delas ut vid föreläsningen. Det finns också tillgängligt på kurshemsidan.

För dig som vill ha VG:

Bevis till Prop. 7.4 och Prop. 7.34.

Kapitel 8. Egenvärden och egenvektorer

Egenvärden och egenvektorer är mycket centralt i linjär algebra och en stor del av kursen

hittills är bakgrundskunskap till detta kapitel. Ändå brukar det inte uppfattas som särskilt

svårt då man till stor del kan följa en standardlösningsgång till de flesta uppgifterna.

När ni senare ska använda egenvärdesteori för att diagonalisera kommer ni troligen endast

ha symmetriska matriser vilka alltid är diagonaliserbara (enl. Sats 8.22). Så det är dessa vi

fokuserar på.

När egenvärden av en 3 × 3-matris ska bestämmas får man tredjegradsekvationer. För att

lösa dessa kan man behöva använda polynomdivision; repetera vid behov i det utdelade

extramaterialet (om trigonometriska funktioner och polynomekvationer).

Ett resultat som inte finns i boken men som är bra att kunna:

Om A = P DP −1 och D är diagonal med egenvärdena λi på diagonalen så gäller

Tr A = Tr D =

Pn

i=1 λi

.

En första enkel kontroll av egenvärden är därför att se om deras summa är lika med spåret

av A (= summan av diagonalelementen i A).

För dig som vill ha VG:

Bevis Prop. 8.6 (det är enkelt så alla borde kunna visa det).

Bevis av Prop. 8.24 i specialfallen n = 2, 3, 4 (generaliseringen bör sedan vara uppenbar)

samt för inversen (n = −1).

6

Kapitel 9. Grafer och grannmatriser

Kapitel 9 ingår inte i kursen. Men en del av det är relativt lättläst så ta gärna en titt på

detta om du är nyfiken på nya områden där matriser används.

Kvadratiska former

Vad en kvadratisk form är och hur den diagonaliseras behöver ni veta när ni senare läser

multivariat statistik. Som litteratur tar vi två texter av Armin Halilovic (de finns tillgängliga

via länk på kurshemsidan). Teorin introduceras kortfattat följt av några exempeluppgifter

med fullständig lösning.

I texten www.syd.kth.se/armin/ALLA KURSER/SF1624/KVADRATISKA FORMER.pdf diagonaliseras kvadratiska former. Sista två sidorna om värdemängden är mindre väsentligt.

I texten www.syd.kth.se/armin/ALLA KURSER/SF1624/ANDRAGRADSKURVOR.pdf används diagonalisering av kvadratiska former för att se hur en andragradskurva ser ur. Uppgift 1 är

viktigast och ni ska känna igen ellipsens ekvation. I Uppgift 3 diagonaliserar man på samma

sätt, men här blir det en hyperbel och ni behöver inte känna igen eller kunna rita den.

Här följer några termer som ni ska känna till (men som tyvärr inte nämns i texterna):

En kvadratisk form (eller dess matris) med . . .

(i) endast positiva egenvärden (λ > 0) är positivt definit.

(ii) endast icke-negativa egenvärden (λ ≥ 0) är positivt semidefinit.

(iii) både positiva och negativa egenvärden är indefinit.

(iv) endast icke-positiva egenvärden (λ ≤ 0) är negativt semidefinit.

(v) endast negativa egenvärden (λ < 0) är negativt definit.

Det är de positivt definita som dyker upp i multivariat statistik.

7