Vektoraddition Multiplikation med skalär Längden av en vektor

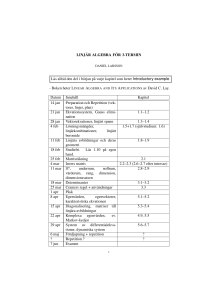

advertisement

Vektoraddition

u+v =

u1

v

+ 1

u2

v2

=

u1 + v 1

u2 + v 2

u1

v1

u1 + v 1

u + v = u2 + v 2 = u2 + v 2

u3

v3

u3 + v 3

Definition

Basvektorer i två dimensioner:

u1

u2

=

α u1

α u2

I två dimensioner

|u| =

I tre dimensioner

|u| =

1

êx = 0

0

Längden av en vektor

êy =

0

1

Basvektorer i tre dimensioner:

u1

α u1

α u = α u2 = α u 2

u3

α u3

1

0

êx =

Multiplikation med skalär

αu = α

Skalärprodukt

Enhetsvektorer

(Adams: êx = i

0

êy = 1

0

êy = j

u•v =

0

êz = 0

1

êz = k)

u1

v

• 1

u2

v2

= u1 v 1 + u2 v 2

u1

v1

u • v = u2 • v 2 = u1 v 1 + u2 v 2 + u3 v 3

u3

v3

Egenskaper

u•v =v•u

Enhetsvektor i riktningen v:

êv =

u • (v + w) = u • v + u • w

α(u • v) = (α u) • v = u • (α v)

1

v

|v|

u • u = |u|2

2

u2

1 + u2

2

2

u2

1 + u2 + u3

Egenskaper hos vektorprodukten

Sats 1: vinkel mellan vektorer

Om θ är vinkeln mellan vektorerna u och

v gäller att

u • v = |u||v| cos θ .

Speciellt gäller att

u•v =0

om och endast om u och v är ortogonala

(dvs vinkelräta).

Om u, v, w ∈ R3 och α ∈ R så gäller

Definition: Vektorprodukt

Om u och v tillhör R3 (dvs är tredimensionella vektorer) så är vektorprodukten u × v

den vektor i R3 som uppfyller tre villkor:

1)

u × v är ortogonal mot både u och v

2)

|u × v| = |u||v| sin θ,

1. u × u = 0

2. u × v = −v × u

3. (u + v) × w = u × w + v × w

där θ är vinkeln mellan u och v

Ortogonal projektion

3)

u, v och u × v bildar en högerorienterad

vektortrippel

Skalärprojektionen s av u på v ges av:

s=

u•v

.

|v|

Vektorprojektionen uv av u på v ges av:

uv =

u•v

u•v

v .

êv =

|v|

|v|2

4. u × (v + w) = u × v + u × w

5. α(u × v) = (αu) × v = u × (αv)

Sats 2: Beräkning av vektorprodukt

u1

v1

u2 v 3 − u3 v 2

u2 × v2 = −(u1v3 − u3v1)

u3

v3

6. u • (u × v) = 0 och v • (u × v) = 0

u1 v 2 − u2 v 1

OBS! OBS! OBS!

I allmänhet gäller att

u × (v × w) = (u × v) × w

Längden av vektorprojektionen är |uv | = |s|.

Planets ekvation

Determinanter

a b = ad − bc

c d

a b c d e f = aei + bf g + cdh − af h − bdi − ceg

g h i a b c e f d f d e − b

+ c

d e f = a h i g i g h

g h i Vektorprodukt som determinant

i

j k u × v = u1 u 2 u 3 v1 v2 v3 u

u

u

u u u = i 2 3 − j 1 3 + k 1 2

v2 v3 v1 v3 v1 v2 Trippelprodukt

Trippelprodukten mellan u, v, w ∈ R3 ges av

Givet en ortsvektor som pekar på en punkt i

planet:

x0

r 0 = y0

z0

och en normalvektor till planet:

u • (v × w).

Den beskriver bl.a. volymen av den parallellepiped som spänns upp av vektorerna (sånär

som på tecknet (±)). Om u, v och w ligger i

samma plan är följdaktligen trippelprodukten

noll.

Trippelprodukten kan också beräknas med en

determinant enligt

u

1 u 2 u3 u • (v × w) = v1 v2 v3 w 1 w 2 w 3

A

n = B

C

så beskrivs planet av alla ortsvektorer

x

r = y

z

som uppfyller

n • (r − r0) = 0.

Om vi utvecklar skalärprodukten erhålls

A(x − x0) + B(y − y0) + C(z − z0) = 0.

Detta går alltid att skriva på formen

A x + B y + C z = D.

Linjens ekvation i tre dimensioner

Ekvationssystem med två linjer

Ekvationssystem med tre plan

Givet en ortsvektor som pekar på en punkt

på linjen:

x0

r 0 = y0

z0

har antingen

en gemensam punkt:

• en gemensam punkt,

• ingen gemensam punkt (ej lösbart), eller

• oändligt många gemensamma punkter.

x2

och en vektor som pekar i linjens rikning:

a

v =b

c

så beskrivs linjen av ortsvektorerna

x 1 — 2x 2 = —1

x1

—x1 + 3x2 = 3

x

r = y

z

oändligt många gemensamma punkter:

x2

som erhålls för alla −∞ < t < ∞ i ekvationen

r = r0 + t v.

x1 — 2x2 = —1

Uttrycket kan också skrivas

x1

—x1 + 2x2 = 3

x = x0 + a t

ingen gemensam punkt (ej lösbart):

.

y = y0 + b t

z = z0 + c t

x2

P.g.a. parametern t, kallas det ovanstående

för parameterform. Adams är förtjust i normalform där man eliminerar t:

y − y0

z − z0

x − x0

=

=

(t =)

a

b

c

x1 — 2x2 = —1

x1

—x1 + 2x2 = 1

Exempel: elementära radoperationer

Matriser

Elementära radoperationer

Exempel:

Det linjära ekvationssystemet

x1 − 2x2 + x3 = 0

2x2 − 8x3 = 8

−4x + 5x + 9x = −9

1

2

3

har koefficientmatris

1. Addera till en rad en multipel av en annan

rad.

3. Multiplicera alla element i en rad med en

konstant skilld från noll.

Två utökade matriser är radekvivalenta om

den ena kan omvandlas till den andra via elementära radoperationer.

Matriser delas in i rader och kolonner.

Elementet −8 ovan befinner sig på rad 2 och

kolonn 3.

1 −2

1

0

1 −2

1 0

∼ 0

4 ∼ 0

1 −4

1 −4 4

0 −3 13 −9

0

0

1 3

1 −2 1 0

1 −2 0 −3

∼ 0

1 0 16 ∼ 0

1 0 16

3

0

0 1 3

0

0 1

Definition: Radekvivalens

1 −2

1

0

2 −8

8

0

−4

5

9 −9

1 −2

1

0

1 −2

1

0

8 ∼ 0

8

0

2 −8

2 −8

−4

5

9 −9

0 −3 13 −9

2. Byt plats på två rader.

1 −2

1

0

2 −8

−4

5

9

och utökad matris

Om två utökade matriser till två linjära

ekvationssystem är radekvivalenta,

så har de samma uppsättning lösningar.

1 0 0 29

∼ 0 1 0 16

0 0 1 3

Den sista utökade matrisen motsvarar systemet

= 29

x1

x2 = 16

x3 = 3

Trappstegsform

Det första elementet som är skillt från

noll i en rad kallas ledande element, eller

pivåelement.

Trappstegsform

Den utökade matrisen

0 −3 −6

4

9

3

1

3 −1

5 −9 −7

−1 −2 −1

−2 −3

0

1

4

kan omvandlas till en radekvivalent matris på

trappstegsform:

1

0

0

0

4

2

0

0

5 −9 −7

4 −6 −6

0 −5

0

0

0

0

Man kan också gå vidare till reducerad

trappstegsform:

1 0 −3

2

0

0 0

0

0 1

0 0

0 −19

0 −3

0

1

0

0

1. Rader som innehåller icke-nollor är

ovanför rader som endast innehåller nollor.

2. Det ledande elementet i en rad ligger till

höger om det ledande elementet i raden

ovanför.

Reducerad trappstegsform

följande villkor tillkommer. . .

4. De ledande elementen har värde 1.

5. Det ledande elementet är det enda elementet som är skillt från noll i sin kolonn.

Exempel:

3. Elementen som ligger under det ledande

elementet i samma kolonn är alla noll.

Exempel:

∗ ∗ ∗ ∗

0 ∗ ∗ ∗

0 0 0 0 0

0 ∗

0 0 0 0 0 0 0

∗ ∗ ∗ ∗ ∗

∗

∗

∗

0 0 0 0 0 0 0

0

0 0 0 ∗ ∗

0 0 0 0 ∗

0 0 0 0 0

∗ ∗

0 0 0

∗

∗

∗

∗

0

∗

∗

∗

∗

0

∗

∗

∗

∗

∗

∗

∗

∗

∗

0 1 ∗ 0 0 0 ∗

∗

∗

∗

0 0 0 0 0 0 0

0 0 0 1 0 0

0 0 0 0 1 0

0 0 0 0 0 1

∗

∗

∗

∗

0

∗

∗

∗

∗

0

0

0

0

0

1

∗

∗

∗

∗

∗

Sats 1

Varje matris är radekvivalent med endast

en reducerad trappstegsmatris.

Variabler som tillhör trappstegsmatrisens ledande element/pivåelement kallas

bundna. Övriga variabler kallas fria.

Vi finner lösningen genom att införa

parametrar för de fria variablerna, och

lösa ut de bundna variablerna med

bakåtsubstitution, dvs vi börjar med

sista ekvationen och går sedan uppåt.

Trappstegsformen ger följande information

Linjära höljet

Vektorekvationer

x1 a 1 + x 2 a 2 + · · · + x n a n = b

som talar om vilka linjärkombinationer av

a1, a2, . . . , an som ger vektorn b, har samma lösningar som ekvationssystemet vars

utökade matris är

1. Om alla variabler är bundna är lösningen

entydig.

2. Om någon variabel är fri, finns oändligt

många lösningar.

3. Om någon ekvation är en falsk utsaga

(ex. 0 = 5), så existerar ingen lösning.

Definition

Vektorekvationen

a1 a2 . . . an b .

Om v 1, v 2, . . . , v p alla tillhör Rn, så

benämns

mängden

av

alla

linjärkombinationer av v 1, v 2, . . . , v p för det

linjära höljet av vektorerna v 1, v 2, . . . , v p

med beteckning

Span{v 1, v 2, . . . , v p}.

Dvs det linjära höljet är alla vektorer som kan

skrivas på formen

Speciellt gäller att b endast kan bildas av

linjärkombinationen om ekvationssystemet är

lösbart.

c1 v 1 + c 2 v 2 + · · · + c p v p .

Observera att 0 alltid ingår i det linjära

höljet.

Matris-vektor-multiplikation

Om A är en m × n-matris (dvs m rader och

n kolonner), med kolonner a1, a2, . . . , an, dvs

A=

a1 a2 . . . an

Låt A vara en m × n-matris. Då är de

följande påståendena ekvivalenta, dvs om

ett är sant så är alla sanna

Ax = b

x1

x

2

x = ..

.

har samma lösningar som vektorekvationen

xn

så definierar vi produkten Ax enligt:

a1 a2 . . . an

Sats 4: Existens av lösning

Sats 3:

Matrisekvationen

och x ∈ Rn är vektorn

x1

x2

Ax =

...

xn

= x 1 a 1 + x2 a 2 + · · · + xn a n

Matrisekvationen Ax = b

x 1 a 1 + x2 a 2 + · · · + x n a n = b

och därmed också samma lösningar som

det linjära ekvationssystem som har

utökad matris

a1 a2 . . . an b

1. Ekvationen Ax = b har lösning för alla

högerled b ∈ Rm

2. Det linjära höljet av kolonnerna i A är

lika med mängen av alla vektorer av

den dimensionen,

dvs om A = [ a1 a2 . . . an ] så är

Span{a1, a2, . . . , an} = Rm

3. A har en pivåposition på varje rad.

dvs som en linjärkombination av kolonnerna

i A med elementen i x som vikter.

Homogena ekvationssystem

Ett linjärt ekvationssystem är homogent om

högerledet endast består av nollor, dvs

A x = 0.

Sats 5: Räkneregler för Ax

Om A är en m × n-matris, u, v ∈ Rn och

c ∈ R, då gäller

1. A(u + v) = Au + Av

2. A(c u) = c(Au)

Inhomogena ekvationssystem

Exempel:

2 −4 −3

x1

0

4 −6 −5 x2 = 0

x3

−2

0

1

0

vilket är samma som

2x1 − 4x2 − 3x3 = 0

4x − 6x2 − 5x3 = 0

+ x3 = 0

1

−2x

1

Homogena ekvationssystem har alltid den

triviala lösningen x = 0.

Icke-triviala lösningar existerar om och

endast om det finns fria variabler.

Sats 6: Lösningsmängd

Om A x = b är ett lösbart ekvationssystem, och xp är en lösning,

så ges alla lösningar av x = xp + xh, där

xh är alla lösningar till det homogena ekvationssystemet A x = 0.

Linjärt (o)beroende

En uppsättning vektorer är linjärt beroende om någon av dem kan beskrivas som en

linjärkombination av de andra.

Detta formuleras enligt:

Sats 8:

Linjärt (o)beroende, forts

Givet ett antal vektorer v 1, v 2, . . . , v p som

alla har dimension Rn:

Enligt definitionen av matris-vektor-multiplikation kan villkoret omformuleras enligt

Om antalet vektorer p är större än vektorernas dimension n, (dvs p > n)

Vetorerna v 1, v 2, . . . , v p är linjärt beroende om det existerar värden x1, x2, . . . , xp

som inte alla är noll, så att

x

1

x2

v 1 v 2 . . . v p .. = 0

.

xp

=A

=x

x1 v 1 + x2 v 2 + · · · + xp v p = 0.

dvs ett homogent ekvationssystem A x = 0.

Definition: Linjärt beroende

så är vektorerna linjärt beroende.

Sats 9:

Om endast den triviala lösningen x = 0 existerar är kolonnerna linjärt oberoende,

Om det ovanstående inte gäller, dvs

annars är de linjärt beroende.

x1 v 1 + x2 v 2 + · · · + xp v p = 0.

Givet ett antal vektorer v 1, v 2, . . . , v p som

alla har dimension Rn:

Om en av dem är nollvektorn, dvs v k = 0

för något k,

så är vektorerna linjärt beroende.

endast är uppfyllt om alla x1, x2, . . . , xp är

noll, säger vi att vektorerna är linjärt oberoende.

Definition: Linjär avbildning

En avbildning T är linjär om

Sats 10: Linjär avbildnings-matris

1. T (u + v) = T (u) + T (v) för alla u, v i

definitionsmängden för T .

2. T (c u) = c (T (u))

skalärer c.

för

alla

u

och

Låt T : Rn −→ Rm vara en linjär avbildning. Då existerar en unik matris A så

att

T (x) = A x,

Definitionen leder till följande egenskaper:

T (0) = 0

för alla

x ∈ Rn .

Matrisen A har dimension m × n, och kolonn k ges av T (êk ), där êk är kolonn k i

enhetsmatrisen In. Dvs

T (c u + d v) = c T (u) + d T (v)

A = T (ê1) T (ê2) . . . T (ên)

T (c1 v1 + c2 v2 + · · · + cp vp)

Definition

Den linjära avbildningen T : Rn −→ Rm är

surjektiv (onto) om värdemängden är hela

Rm. Dvs om varje y ∈ Rm ges av y = T (x)

för något x ∈ Rn.

injektiv (one-to-one) om varje y i avbildningen y = T (x) endast ges av ett x ∈ Rn.

(Dvs T (u) = T (v) ⇒ u = v.)

= c1 T (v1) + c2 T (v2) + · · · + cp T (vp)

Matrisaddition

Matriser

Sats 11: Injektiva avbildningar

Den linjära avbildningen T : Rn −→

Rm är

injektiv om och endast om T (x) = 0 bara

har den triviala lösningen x = 0.

(Dvs om och endast om kolonnerna i avbildningsmatrisen är linjärt oberoende).

Sats 12: Surjektiva avbildningar

Den linjära avbildningen T : Rn −→ Rm

med avbildningsmatris A är surjektiv om

och endast om det linjära höljet till kolonnerna i A är lika med Rm.

Sats 4 ger då att A är surjektiv om och endast om A har en pivåposition på varje rad.

Matriser delas in i rader och kolonner. En

m × n-matris (m rader och n kolonner) med

obestämda element skrivs

a12 · · · a1j · · · a1n

a22 · · · a2j · · · a2n

...

...

...

.

ai2 · · · aij · · · ain

...

...

...

am1 am2 · · · amj · · · amn

Elementet på rad i och kolonn j benämns aij .

Diagonalelementen a11, a22, a33, . . . bildar

matrisens huvuddiagonal:

a11

a21

.

..

A=

a

i1

..

.

a11

A = a21

a31

Matriser

med

lika många rader

och

lika många kolonner adderas elementvis.

Dvs om C = A + B, så bildas alla element i

C av cij = aij + bij . Ex:

a12

a22

a32

a13

a23

a33

a14

a24

.

a34

En matris som endast består av nollor kallas

nollmatris och skrivs 0.

a11

a

21

a31

a41

a11

a

= 21

a31

a41

a12

a22

a32

a42

a13

b11

b

a23

+ 21

a33 b31

a43

b41

+ b11

+ b21

+ b31

+ b41

a12 + b12

a22 + b22

a32 + b32

a42 + b42

b12

b22

b32

b42

b13

b23

b33

b43

a13 + b13

a23 + b23

a33 + b33

a43 + b43

Multiplikation med skalär

Om B = k A, så bildas alla element i B av

bij = k aij . Ex:

a11 a12 a13

k a11 k a12 k a13

k a21 a22 a23 = k a21 k a22 k a23

a31 a32 a33

k a31 k a32 k a33

Egenskaper

Om matriserna A, B och C har samma storlek, och r och s är skalärer, så gäller följande

samband

1. A + B = B + A

2. (A + B) + C = A + (B + C)

Matrismultiplikation

Matrismultiplikation, smart genväg

Om A är en m × n-matris och B är en n × pmatris, så definierar vi produkten mellan A

och B som en matris C med storlek m × p

enligt

Om C = AB så kan vi beräkna elementet

i C på rad i och kolonn j genom att ta

skalärprodukten mellan rad i i A och kolonn j i B. dvs

C = AB = A b1 b2 . . . bp

3. A + 0 = A

= Ab1 Ab2 . . . Abp

4. r(A + B) = rA + rB

5. (r + s)A = rA + sA

cij = ai1b1j + ai2b2j + · · · + ainbnj

=

n

k=1

där b1, b2, . . . , bp är kolonnerna i B.

aik bkj

6. r(sA) = (rs)A

Transponat

Egenskaper

Om A är en m × n matris, och B och C har

”lämpliga storlekar”, så gäller följande samband

Givet en m × n-matris A så definierar vi

transponatet till A som den n × m-matris

AT man får genom att byta plats på rader

och kolonner.

Egenskaper

Om A och B är matriser av ”lämpliga storlekar”, så gäller följande samband

1.

1. A(BC) = (AB)C

Exempelvis om

2. A(B + C) = AB + AC

1 2 3 4

A = 5 6 7 8

9 10 11 12

3. (B + C)A = BA + CA

4. r(AB) = (rA)B = A(rB) där r är en skalär

så ges transponatet av

5. ImA = A = AIn

1 5

9

AT

T

=A

2. (A + B)T = AT + B T

3. (r A)T = r AT

där r är en skalär

4. (AB)T = B T AT

2 6 10

AT =

3 7 11

OBS!!! I allmänhet gäller att AB = BA.

Egenskap 4. kan generaliseras till, exempelvis

(ABCDE)T = E T DT C T B T AT

4 8 12

Sats 5: Linjära ekvationssystem

Matrisinvers

Vi betraktar här endast kvadratiska matriser, dvs matriser med lika många rader som

kolonner.

Om A är en n × n-matris och det existerar en

annan n × n-matris C som uppfyller att

AC = I

och

CA = I

så säger vi att A är inverterbar och har invers C.

Inversen till A betecknas vanligen A−1 och

uppfyller alltså

AA−1 = I

och

A−1A = I

Matrisen A−1 är entydigt bestämd eftersom

det endast finns en invers till varje inverterbar

matris.

Om A är en inverterbar n × n-matris, så

har det linjära ekvationsystemet Ax = b

entydig lösning för alla b ∈ Rn, och

lösningen ges av

x = A−1b

Sats 7:

Sats 6:

a. Om A är inverterbar, så är A−1 inverterbar och

A−1

−1

=A

b. Om A och B är inverterbara n × nmatriser, så är AB inverterbar och

(AB)−1 = B −1A−1

c. Om A är inverterbar, så är också AT

inverterbar och

AT

−1

= A−1

T

En

n × n-matris

A

är

inverterbar

om och endast om A är radekvivalent

med In.

För inverterbara matriser gäller att varje

sekvens av elementära radoperationer

som reducerar A till In, också avbildar In

på A−1.

(−1)1+j a1j det(A1j )

n

där Aij är den matris som erhålls om rad i och kolonn j tas bort från

A.

Om A är en n × n-matris som ej är inverterbar säger vi att A är singulär.

j=1

j. Det finns en matris C så att CA = In.

k. Det finns en matris D så att AD = In.

l. AT är inverterbar.

=

g. Ax = b har lösning för varje b.

h. Kolonnerna i A spänner upp Rn.

i. Avbildningen x → Ax är surjektiv.

Definition: determinant

d. Den homogena ekvationen Ax = 0 har

endast den triviala lösningen x = 0.

e. Kolonnerna i A är linjärt oberoende.

f. Avbildningen x → Ax är injektiv.

det(A) = a11 det(A11) − a12 det(A12) + · · · + (−1)1+n a1n det(A1n)

a. A är inverterbar.

b. A är radekvivalent med In.

c. A har n pivåpositioner.

Determinanten till en n × n-matris, då n ≥ 2, är en viktad summa av

determinanter till n st. (n − 1) × (n − 1)-matriser enligt formeln

Låt A vara en n × n-matris. Då är de

följande påståendena ekvivalenta, dvs om

ett är sant så är alla sanna.

Determinanten till en 1 × 1-matris är matrisens skalära värde (ex.

det[5] = 5).

Sats 8: Inverterbarhet

Utveckling efter rad och kolonn

Låt

Cij = (−1)i+j det(Aij )

beteckna kofaktorn för rad i och kolonn j

till matrisen A. Då gäller enligt definitionen

av determinant

det(A) = a11 C11 + a12 C12 + · · · + a1n C1n.

Detta är utvecklingen efter rad 1. Man kan

dock utveckla efter en godtycklig rad eller

kolonn

Sats 1

Utveckling efter rad i:

det(A) = ai1 Ci1 + ai2 Ci2 + · · · + ain Cin

Utveckling efter kolonn j:

det(A) = a1j C1j + a2j C2j + · · · + anj Cnj

Sats: Inverterbarhet

Sats 2

Om A är en triangulär matris, så är

det(A) produkten av elementen på diagonalen av A.

Sats 4

En kvadratisk matris A är inverterbar,

om och endast om det(A) = 0.

Sats 3: Radoperationer

Låt A vara en kvadratisk matris.

a. Om matrisen B bildas genom att ta

en multipel av en rad i A och lägga

till en annan, så gäller

Sats 5

Om A en kvadratisk matris så gäller

det(AT ) = det(A)

det(B) = det(A).

b. Om B bildas genom att byta plats på

två rader i A, så gäller

det(B) = −det(A).

c. Om B bildas genom multiplicera en

rad i A med k, så gäller

Sats 6

Om A och B är n × n-matriser så gäller

det(A B) = det(A) det(B)

det(B) = k det(A).

Låt A vara en n × n-matris. Då är de

följande påståendena ekvivalenta, dvs om

ett är sant så är alla sanna.

a. A är inverterbar.

b. A är radekvivalent med In.

c. A har n pivåpositioner.

d. Den homogena ekvationen Ax = 0 har

endast den triviala lösningen x = 0.

e. Kolonnerna i A är linjärt oberoende.

f. Avbildningen x → Ax är injektiv.

g. Ax = b har lösning för varje b.

h. Kolonnerna i A spänner upp Rn.

i. Avbildningen x → Ax är surjektiv.

j. Det finns en matris C så att CA = In.

k. Det finns en matris D så att AD = In.

l. AT är inverterbar.

t. det(A) = 0.

Om A är en n × n-matris som ej är inverterbar säger vi att A är singulär.

Kofaktorn Cij ges av

Låt Ai(b) beteckna den matris man får om

man byter ut kolonn i i A mot vektorn b,

dvs

Sats 9

Om A är en 2 × 2-matris så är |det(A)|

arean av parallellogrammet som spänns

upp av kolonnerna i A.

Om A är en 3 × 3-matris så är |det(A)|

volymen av parallellepipeden som spänns

upp av kolonnerna i A.

Ai(b) = [ a1 a2 . . . b . . . an]

↑

pos. i

Sats 7: Cramers regel

Om A är en inverterbar n × n-matris, och

b ∈ Rn, så ges elementen i lösningen x till

A x = b av

xi =

det Ai(b)

det A

Cij = (−1)i+j det(Aij )

där Aij är den matris man får om man tar

bort rad i och kolonn j ur A.

Den adjungerade matrisen till A ges av

C11 C21 · · ·

C

C22 · · ·

adj A = ..12

...

.

Cn1

Cn2

...

C1n C2n · · · Cnn

Observera att rad och kolonnindex har ”bytt

plats”.

Sats 8:

Om A är en inverterbar n × n-matris. Då

är

1

A−1 =

adj A

det A

{volymen av T (S)} = |det(A)| · {volymen av S}

Låt istället T : R3 −→ R3 vara den linjära avbildning som

alstras av 3 × 3-matrisen A. Om S är en parallellepiped

i R3, så är

{arean av T (S)} = |det(A)| · {arean av S}

Låt T : R2 −→ R2 vara den linjära avbildning som alstras

av 2 × 2-matrisen A. Om S är ett parallellogram i R2,

så är

Sats 10

Ett generellt område approximerat med ”parallellogram”:

0

0

R’

0

Linjär avbildning av approximerat område:

T

0

T(R’)

Slutsats: Sats 10 gäller för generella begränsade områden.