Föreläsning 8. - UU Studentportalen

advertisement

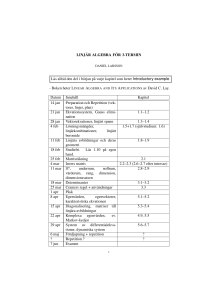

Föreläsning 8. Jesper Rydén Matematiska institutionen, Uppsala universitet [email protected] Tillämpad statistik för STS • vt 2014 Exempel: Pris och boyta I Samband mellan två eller flera variabler? I Spridningsdiagram kan indikera samband I Matematisk/stokastisk modell? Enkel linjär regression Observationer y1 , . . . , yn av variablerna Y1 , . . . , Yn , antas oberoende med gemensam varians σ 2 . Väntevärdet µi = E[Yi ] beror på givna storheter. Enkel linjär regression: µi = α + β xi , i = 1, . . . , n Linjär syftar på uttryckets linjäritet i parametrarna (α, β). Även t.ex. µi = α + β1 xi + β2 xi2 + β3 sin xi innebär (multipel) linjär regression. Modell Låt x1 , . . . , xn vara givna (icke slumpmässiga) storheter. Antag vidare att Y1 , . . . , Yn är oberoende slumpvariabler med gemensam varians σ 2 och att µi = α + βxi . Vi har då en enkel linjär regressionsmodell. Storheten x kallas regressor eller förklarande variabel eller oberoende variabel. Slumpvariabeln Y (eller dess observerade värde y ) kallas för responsvariabel eller beroende variabel. Linjen för väntevärdet y = α + βx kallas för den teoretiska regressionslinjen, α benämnes intercept och β lutningskoefficient. Enkel linjär regression Minstakvadratmetoden används för att finna punktskattningar. Sök de parametrar som minimerar Q= n X (yi − α − βxi )2 . i=1 Man finner punktskattningarna Pn yi xi − nx̄ ȳ ∗ , β = Pi=1 n 2 2 i=1 xi − nx̄ där ȳ = n−1 P yi och x̄ = n−1 P α∗ = ȳ − β ∗ x̄, xi . Skattad modell: yi∗ = α∗ + β ∗ xi med residualer ei = yi − yi∗ Idé: Minimera kvadratsumma Historisk kommentar: MK-metoden “The method of least squares is the automobile of modern statistical analysis: despite its limitations, occasional accidents, and incidental pollution, it and its numerous variations, extensions, and related conveyances carry the bulk of statistical analyses, and are known and valued by nearly all. But there has been some dispute, historically, as who was the Henry Ford of statistics.” SM Stigler (1981) En vetenskaplig dispyt Adrien-Marie Legendre Carl Friedrich Gauss (1752-1833) (1777-1855) Publikation om metoden 1805. Publikation om metoden 1809. J.D. Forbes’ experiment Estimate altitude above sea level from measurements of boiling point of water. Motivation: Difficulties in transportation of fragile barometers. 32 Barometric pressure (inches Hg) 30 28 26 24 22 20 195 200 205 Boiling point (F) 210 Residuals (Forbes’ data) 0.8 Residual value 0.6 0.4 0.2 0 −0.2 −0.4 0 2 4 6 8 10 12 Residual number 14 16 Residuals (Forbes’ data) Normal probability plot 5 4 Quantile 3 2 1 0 −1 −2 −0.4 −0.2 0 0.2 Data 0.4 0.6 0.8 Varning: Orsak/verkan Beakta variablers inverkan! Datas karaktär: tvärsnittsdata (insamlat vid en given tidpunkt) eller longitudinella (insamlade över tid). Datainsamling? Experiment, enkäter; samhällsvetenskap/naturvetenskap. Förklaringsgrad: Enkel linjär regression Förklaringsgrad: Pn e2 R 2 = 1 − Pn i=1 i 2 i=1 (yi − ȳ ) Det gäller alltid 0 ≤ R 2 ≤ 1. Ju närmare R 2 = 1, desto bättre anpassning För enkel linjär regression gäller R 2 = r 2 där r 2 är den kvadrerade skattade korrelationskoefficienten. Enkel linjär regression: prediktion av väntevärde Givet x = x0 , prediktera värdet av beroende variabeln y genom att använda linjen: y0∗ = α∗ + β ∗ x0 Man finner E[Y0∗ ] = α + βx0 (x0 − x̄)2 ∗ 2 1 + Pn V[Y0 ] = σ 2 n i=1 (xi − x̄) Enkel linjär regression: prediktionsintervall En framtida observation y0 svarande till x0 ; vi är intresserade av differensen y0 − y0∗ . E[Y0 − Y0∗ ] = 0 V[Y0 − Y0∗ ] = V[Y0 ] + V[Y0∗ ] (x0 − x̄)2 1 2 = σ 1 + + Pn 2 n i=1 (xi − x̄) Forbes’ data Barometric pressure (inches Hg) 32 30 28 26 24 22 20 18 190 195 200 205 Boiling point (F) 210 215 Regression med fel i bägge variablerna * EIV-modell (Error In Variables). Givet: observationspar (x1 , y1 ), . . . , (xn , yn ). xi = ξi + δi yi = β0 + β1 ξi + i där ξi är okända värden och δi samt i är oberoende fel med varianser σδ2 resp. σ2 . MK- och ML-skattningar kan härledas. Multipel regression Beroende variabel (responsvariabel): y Oberoende variabler (förklarande variabler, regressorvariabler, carriers): x1 , x2 , . . . , xk Matematiskt samband: y = f (x1 , x2 , . . . , xk ) där f () är en funktion. Linjär modell Exempel, p = 2: y = β0 + β1 x1 + β2 x2 + OBS! Linjäriteten avser parametrarna βi . Även y = β0 + β1 x1 + β2 x2 + β11 x12 + β22 x22 + β12 x1 x2 + är att betrakta som en linjär modell. Responsytor, exempel 1 y = 35.5 + 10.5x1 + 5.5x2 + 0.5x1 x2 Responsytor, exempel 2 y = 35.5 + 10.5x1 + 5.5x2 + 8x1 x2 Multipel regression: matrisnotation Matrisnotation: y = Xβ + där y= y1 y2 .. . , X= yn och β= β0 β1 .. . βk 1 x11 x12 . . . xik 1 x21 x22 . . . x2k .. .. . .. . .. . . 1 xn1 xn2 . . . xnk , = 1 2 .. . n Enkel linjär regression: matrisnotation Matrisnotation: y = Xβ + där y= y1 y2 .. . X= , yn och 1 x1 1 x2 .. .. . . 1 xn β= β0 β1 , = 1 2 .. . n MK-metoden för estimering av parametrar Miniminera L(β) = (y − Xβ)T (y − Xβ) vilket leder till normalekvationerna XT X β = X T y och MK-skattningen b = (XT X)−1 XT y β Anmärkning. Vid numerisk behandling används ofta en QR-faktorisering av matrisen X. Anpassade värden och hattmatris Anpassade värden ŷ ges av ŷ = X β̂ = Hy där H = X(XT X)−1 XT ofta kallas hattmatrisen. Residualer: e = y − ŷ Mer om skattningar Väntevärdesriktig skattning med Egenskaper hos skattningen β̂ Cov(β̂) = σ 2 (XT X)−1 Skattning av σ 2 Inför residualkvadratsumman T Q0 = SSE = e e = n X (yi − ŷi )2 i=1 En väntevärdesriktig skattning ges av σ̂ 2 = Q0 n−k −1 och vidare gäller σ12 Q0 ∈ χ2 (n − k − 1) (följer av räkneregler för linjärkomb. av stok. vektor) Spjälkning av kvadratsummor Man kan visa att n n n X X X (yi − ȳ )2 = (ŷi − ȳ )2 + (yi − ŷi )2 i=1 i=1 i=1 Tolkning: Total variation = Förklarad variation + Oförklarad variation Vanlig engelsk beteckning: SST = SSR + SSE Kompendium: QTOT = QREGR + QRES Förklaringsgrad Förklaringsgrad (coefficient of multiple determination): R2 = SSE SSR =1− SST SST Ju fler förklarande variabler, desto högre värde på R 2 . Emellanåt används dessutom en besläktad storhet. Justerad förklaringsgrad (adjusted R 2 statistic): n−1 SSE /(n − k − 1) 2 Radj = 1 − =1− (1 − R 2 ) SSR /(n − 1) n−k −1 Statistisk analys: Test av regression Antag att i ∈ N(0, σ 2 ). Hypoteser: H0 : β1 = β2 = · · · = βk = 0 H1 : βj 6= 0 för minst ett j Teststorhet: F0 = SSR /k SSE /(n − k − 1) Förkasta H0 om F0 > Fα (n − k − 1). SSE SSR T = yT y − β̂ XT y P ( ni=1 yi )2 T T = β̂ X y − n Test av enskilda parametrar Hypoteser: H0 : βj = 0 mot H1 : βj 6= 0 Beteckna i matrisen (XT X)−1 elementen med cij . Då gäller βj ∼ N(βj , σ 2 cjj ). Teststorhet: β̂j − 0 t0 = p σ̂ 2 cjj Förkasta H0 om |t0 | > tα/2 (n − k − 1). Konfidensintervall Ett 100(1 − α) % konfidensintervall för βj , j = 0, 1, . . . , k, ges av q q 2 2 β̂j − tα/2 (n − k − 1) σ̂ cjj , β̂j + tα/2 (n − k − 1) σ̂ cjj Konfidensintervall för väntevärde vid x0 : q T T 2 T −1 x0 β̂ ± tα/2 (n − k − 1) σ̂ x0 (X X) x0 Prediktionsintervall vid vid x0 : q T T 2 T −1 x0 β̂ ± tα/2 (n − p) 1 + σ̂ x0 (X X) x0 Exempel med R: Miljögifter och fiskar Studier av DDT-halten hos fiskarter utefter en flod i Alabama. En kemisk industri finns belägen längs floden. Totalt gjordes mätningar på 144 fiskar. De fem första observationerna: 1 2 3 4 5 River FCM FCM FCM FCM FCM Mile 5 5 5 5 5 Species CCATFISH CCATFISH CCATFISH CCATFISH CCATFISH Length 42.50 44.00 41.50 39.00 50.50 Weight 732 795 547 465 1252 DDT 10.00 16.00 23.00 21.00 50.00 Exempel med R: Miljögifter och fiskar Antag att vi vill skatta parametrar i modellen y = β0 + β1 x1 + β2 x2 + β3 x3 + Responsvariabel: y =DDT Förklarande variabler: x1 =Mile, x2 =Length, x3 =Weight Call: lm(formula = DDT ∼ Mile + Length + Weight, data = fishes) (Intercept) Mile Length Weight Estimate -108.0677 0.0851 3.7709 -0.0494 Std. Error 62.7004 0.0822 1.6189 0.0293 t value -1.72 1.03 2.33 -1.69 Pr(>|t|) 0.0870 0.3025 0.0213 0.0935 Residual standard error: 97.48 on 140 degrees of freedom Multiple R-squared: 0.03887, Adjusted R-squared: 0.01827 F-statistic: 1.887 on 3 and 140 DF, p-value: 0.1345 Miljögifter och fiskar (a) Ange en skattning av standardavvikelsen σ för . Från R-utskriften finner vi direkt σ ∗ = 97.48. (b) Ger data tillräckligt belägg för att dra slutsatsen att DDT-halten ökar med ökande längd (signifikansnivå 0.05)? Hypotestest: H0 : β2 = 0 H1 : β2 > 0 Från R-utskriften finner vi värde på teststorheten för t-test: t = 2.33. Under antagande om normalfördelade residualer . förkastas H0 om t > t0.05 (142) = 1.66, dvs. vi förkastar här H0 . Alternativt, studera motsvarande p-värde för aktuell variabel (ges i utskriften): p = 0.0213/2 = 0.01065. Slutsats: Förkasta H0 på nivån 0.05. Miljögifter och fiskar (c) Beräkna ett 95% konfidensintervall för β3 . Tolka intervallet. Ett intervall ges av Iβ3 = [β3∗ ± t0.025 (142)d[β3∗ ] ] R-utskriften: . . β3∗ = −0.0494 och medelfelet d[β3∗ ] = 0.0293. . Tabell eller dator ger t0.025 (142) = 1.98. Intervallet ges av [−0.11, 0.0085]. Tolkning: För varje grams ökning av fiskens vikt kan vi med 95% säkerhet slå fast att ökningen i DDT-halt ligger i intervallet [−0.11, 0.0085], om övriga variabler i modellen, Mile och Length, hålls konstanta. Miljögifter och fiskar (d) Testa regressionsmodellen på signifikansnivån 0.05. Hypotestest: H0 : β1 = β2 = β3 = 0 H1 : Minst ett βi 6= 0 Detta kan testas med ett F-test, värdet på teststorheten kan utläsas: F = 1.89. H0 förkastas om F > F0.05 (3, 140) = 2.67, dvs. i detta fall förkastas inte H0 . Motsvarande p-värde kan utläsas: p = 0.1345; förkasta inte H0 på någon av de vanligast förekommande nivåerna. De förklarande variablerna förklarar inte tillräckligt bra responsvariabeln.